El Monumento Nacional del Gran Cañón protegerá a las comunidades indígenas, la vida silvestre, los suministros de agua y la recreación

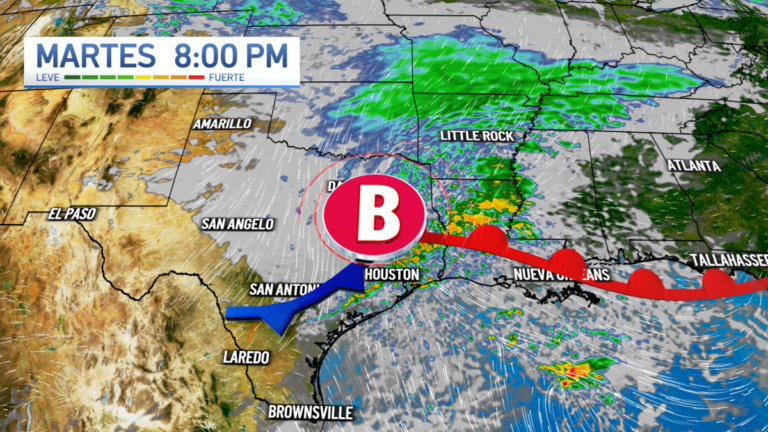

Mapa Iteractivo de Desastres

Conteo de la Mariposa Monarca

El número de mariposas monarca del oeste aumentó en el último conteo invernal con respecto al ano pasado, pero el cambio climático sigue afectando a esta especie que hace un extraordinario recorrido de 4,000 kilómetros desde Estados Unidos y Canadá, donde se reproducen, hasta los bosques del centro de México, donde pasan el invierno.

Tomemos acción para salvar el parque de la amistad

La Patrulla Fronteriza de los Estados Unidos pronto comenzará a instalar dos muros de 30 pies en el área del Parque de la Amistad, el histórico lugar de encuentro binacional situado en el extremo más occidental de la frontera entre los Estados Unidos y México, justo al sur de la ciudad de San Diego.

Legislación de justicia ambiental ayudará a las comunidades marginadas

National Wildlife Federation, insta al Congreso a que apruebe el proyecto legal denominado, “Ley de Justicia Ambiental para Todos, A. Donald McEachin”, reintroducido en el Congreso por los representantes, Raúl Grijalva (D-Ariz) y Barbara Lee (D-Calif) y los senadores, Tammy Duckworth (D-Ill) y Cory Booker (D-NJ

100 preguntas oficiales del examen de ciudadanía en inglés

Estas son las 100 preguntas oficiales de ciudadanía americana en inglés (2023). Las preguntas están en la parte cívica de la prueba de ciudadanía. La mayoría de los solicitantes tomarán su examen de ciudadanía en inglés. Sin embargo, si primero desea aprender las preguntas de cívica en español, puede hacerlo haciendo clic aquí.

Faithful Friends

Campaña para cerrar la carcel de Yuba y provee apoyo moral y económico a las personas en centros de detención.

Transmitiendo desde San Francisco, California.

Escuchanos en cualquier parte del mundo.

Politica ⇅

El Mundo ⇅

Locales ⇅

Estados Unidos ⇅

¿Quieres hablar con nosotros en cabina?

Nuestros Horarios en el Estudio:

9am a 11am | 12m a 1pm | 4 a 5 pm | 5 a 6pm

horario del pacifico

Inmigración ⇅

Economía ⇅

Deportes ⇅

Curiosidades ⇅

Cultura y Educación ⇅

Tecnología ⇅

Salud ⇅

Religión ⇅

Entretenimiento ⇅

Medio Ambiente ⇅